La IA es una de las herramientas más atractivas actualmente. Esta puede ser de ayuda o no, dependiendo del uso que se le dé. Si bien estrategias como los ‘deepfake’ no se han posicionado completamente en Ecuador hay que tomar medidas preventivas antes de que lleguen.

A pesar de que el origen de la inteligencia artificial (IA) se puede remontar a la década de 1950, todavía no cuenta con una sola definición universal. La Real Academia Española (RAE) la define como una “disciplina científica que se ocupa de crear programas informáticos que ejecutan operaciones comparables a las que realiza la mente humana, como el aprendizaje o el razonamiento lógico”. Por su parte, la Comisión Europa ofrece un significado más amplio, pues dice que la IA tiene sistemas de software (y posiblemente hardware) que perciben su entorno en forma de datos. La inteligencia artificial los interpreta y estudia de tal manera que decide “las mejores acciones a tomar para alcanzar el objetivo dado”.

Tales objetivos pueden variar según los ejecutores. Unos pueden usarla para potenciar campañas de marketing en redes sociales o avanzar más rápido con trabajos mecánicos digitales. Sin embargo, también se la puede utilizar para desinformar por medio de la creación de contenido nuevo que puede pasar como verídico.

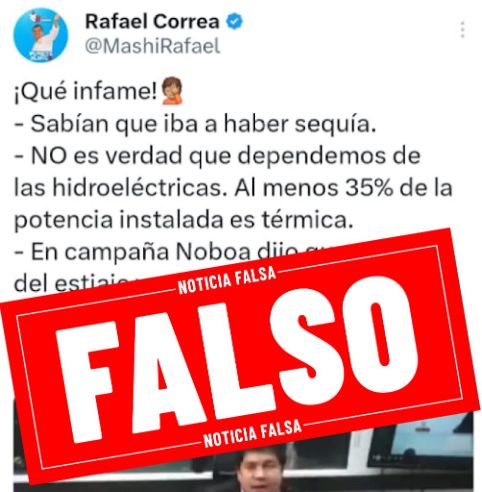

“Siempre van a haber personas que utilicen mal este tipo de herramientas”, admite José Rivera, director de la agencia de marketing digital Tikinauta. Él destaca que hay un impacto negativo de la IA cuando se envían mensajes desinformativos por canales como WhatsApp o las Redes Sociales. Generalmente estos son distribuidos por “personas inescrupulosas con intereses políticos detrás, tratando de perjudicar a otras personas o tratando posicionar un discurso que les convenga”.

Cuando se genera contenido desinformativo con inteligencia artificial se lo conoce como ‘deepfakes’ o ‘falsedades profundas’. Esto incluye todo tipo de archivo de video, imagen o voz generado con inteligencia artificial y que imita la apariencia y sonido de una persona, así lo explica la compañía Seon, dedicada a soluciones integrales en prevención del fraude con herramientas digitales. “Es tan convincente para imitar lo que real que puede engañar tanto a las personas como a los algoritmos”, dice.

En Ecuador, se vio un ejemplo de esto el 24 de junio, cuando se decía que el diario Extra habría publicado que The New Yorker filtra audio de entrevista al presidente, Daniel Noboa. La nota se refería al perfil que el periodista estadounidense Jon Lee Anderson publicó sobre Noboa. El periodista le confirmó a Ecuador Chequea que el audio es falso y apuntó a que pudo ser creado con inteligencia artificial, cuyo caso se conoce como ‘deepvoice’.

A pesar de la influencia que tiene la inteligencia artificial para contribuir con la desinformación, José Rivera resalta que esta “La mala utilización que hacen las personas de la IA puede contribuir a la desinformación”.

Por ello, el comunicador considera que se deben establecer lineamientos con los que la población adquiera conciencia del potencial de la herramienta y “para que sepan cómo usarla y aplicarla en la construcción de la sociedad y no en la destrucción de los demás”.

En noviembre del 2021, la Unesco desarrolló la primera norma mundial sobre la ética al manejar la IA. En la ‘Recomendación sobre la ética de la inteligencia artificial’ se despliegan 4 valores y 10 principios, algunos de los cuales son: respeto, protección y promoción de los derechos humanos; prosperidad del medio ambiente; equidad y no discriminación; derecho a la intimidad, entre otros. El documento fue adoptado por los 193 estados miembros, incluido Ecuador. Sin embargo, el país no cuenta con una norma ética independiente.

Si se utiliza la IA de forma descontrolada, el principal riesgo es “la manipulación de la audiencia”, advierte Diego Palacios, director y productor de contenidos audiovisuales de UDLA Channel. “Se pueden manipular a las personas a las que uno quiere llegar, cualquiera que sea el fin, como robar datos, desestabilizar, generar pánico, etc”.

El experto destaca que la desinformación con inteligencia artificial no es generada por una sola persona, sino por una organización estructurada con un objetivo definido. Por fortuna, tal nivel de orden todavía no se ha visto fuertemente en Ecuador, pues Ecuador Chequea no ha verificado tantos contenidos realizados con IA.

No obstante, este no es un dato con el que relajarse, sino con el prevenir. Palacios explica que otros países como Estados Unidos o España cuentan con políticas de control porque ya se han visto afectados por la inteligencia artificial. A Ecuador la IA “va a llegar de forma más estabilizada”, pues ya tuvo su ‘período de prueba’ fuera.

Los ecuatorianos escogerán un nuevo jefe de Estado en febrero del 2025; sin embargo, desde ahora han comenzado a circular notas desinformativas al respecto. Si bien, por el momento, sólo ha surgido una asistida por la IA, Palacios reconoce que es “altamente probable” que se las use en esta época, sobre todo por WhatsApp “el canal de preferencia de los deepfakes para llegar a la audiencia”. Tal favoritismo se da por los controles que han dispuesto otras plataformas sociales. Por ejemplo, Instagram detecta cuando una publicación fue generada con IA, por lo que le da la opción al usuario de registrarla como tal; si no lo hace, la aplicación puede bloquear el contenido.

Los más vulnerables a caer en tales trampas son los grupos etarios “más inocentes” como los llama Palacios. Es decir, los jóvenes entre 16 y 19 años y los adultos mayores de más de 55 años. Esta población resulta más afectada cuando se usurpan las voces e imágenes de periodistas reconocidos, como sucedió a inicios de junio cuando circulaban videos falsos de los periodistas Juan Carlos Aízprua, Andrés Jungbluth y Gisella Bayona.

José Rivera reconoce que “cada vez es más complicado reconocer un deepfake”. Sin embargo, hay que fijarse bien en los detalles para poder identificarlos. Los audios son los más complicados; aunque, se puede lograr concentrándose en la finalización de las palabras y la separación de las frases, donde pueden haber irregularidades.

Un ejemplo de esto se dio el 4 de junio, cuando circulaba en internet que Nayib Bukele se habría referido a Noboa y a Milei en su discurso presidencial. Con ayuda de la herramienta Deepware, Ecuador Chequea determinó que el supuesto discurso del mandatario salvadoreño fue generado con inteligencia artificial. En caso de no percibir irregularidades en el audio se puede recurrir al instrumento, que es capaz de reconocer videos generados.

Hay algunos casos de deepfake conocidos como ‘face swap’ o ‘intercambio de caras’. Estos se dan cuando se toma la cara de otra persona, generalmente del ámbito público, y se lo pone en el cuerpo de alguien más. Si bien en Ecuador todavía no se dan estos casos, vale la pena saber que hay que fijarse en la pronunciación de las palabras, que no suele estar sincronizadas con el audio. José Rivera destaca que los rostros todavía no son perfectos, por lo que hay que buscar parpadeos irregulares, falta de sombras o iluminación extraña, detalles anómalos en el cabello o no moverse de forma natural, ojos vidriosos o sin enfocar y, ver las líneas del cuello y las orejas, que no suelen corresponder con el cuerpo.

Un caso similar al ‘intercambio de caras’ se dio el 12 de marzo, cuando se viralizó un video de TikTok donde se decía que la hija de Correa quiere ser candidata presidencial en el 2025. Entonces, Ecuador Chequea logró determinar que se trataba de un contenido falso, ya que el personaje mostraba movimientos firmes y poca fluidez en su discurso. Además, no se encontraron declaraciones oficiales al respecto.

“Nos hemos vuelto una sociedad pasiva, que puede ser muy frágil e inocente a creer este tipo de cosas”, resalta Diego Palacios. Para combatir a la desinformación generada con IA, Palacios apunta a que se debe “educar y alfabetizar en el mundo digital”. En otras palabras, darle a las audiencias herramientas con las que criticar, dudar y reflexionar sobre el contenido que consume. En este sentido, Ecuador Chequea recomienda apoyarse en la página web Deepfake Detector cuando se duda de que un audio o video sea real y original. De igual forma, cuando el movimiento del rostro de una persona resulta irregular se puede verificar su origen con Face Recognition Software.